【IBC 2022】レポート#2 放送におけるオブジェクトコンテンツ化とメタバースとの関係

デジタルメディアコンサルタント 江口 靖二 氏

IBC2022では、DVBやEBUが放送でのOBM(Object-Based Media)化とメタバースに関する展示やセッションを多数開催した。欧州ではこうした新しい放送サービスを念頭に置いた上で、DVBでの標準化作業が行われている。

放送業界でコンテンツについて話すとき、いまだに「ライブラリ」や「アーカイブ」という言葉を用いることがある。ビデオやオーディオの番組は、たとえそれがメタデータを持つデジタルアセットであっても、固定化されて自己完結したブラックボックスとしてのみ考えられていることは機会と利便性を遺失している。

OBM(Object-Based Media)とは何か

OBMはBBCのラボを中心にして研究されてきたオブジェクトベースのメディア概念である。オブジェクトベースとは、従来の放送のようにコンテンツ全体を単一のアセット、造り手側の意思のみに基づいた完パケとしてだけ配信するのではなく、個々のオブジェクアセットとして提供し、端末側で視聴者ごとにオブジェクトを再構築するものだ。OBMを用いて放送を行う場合はOBB(Object-Based Broacast)という。OBMは、ユーザーやデバイスのさまざまな要求に応えるために、さまざまな方法で組み立てることができるメディアコンテンツを作る方法である。最もわかり易い例としては、すでに行われている字幕放送のうちクローズドキャプションは、必要に応じてオン・オフできるので広義でいうOBMと言える。

OBMにおけるオブジェクトとは、コンテンツの一部を構成するために使用されるさまざまなアセットを指す。ドラマの1シーンに使われるオーディオやビデオといった大きなオブジェクトもあれば、ビデオの個々のフレーム、キャプション、デジタル署名といった小さなオブジェクトまでさまざまだ。

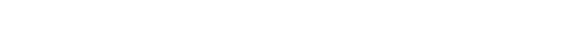

英国の放送通信庁あでるOfcomが2021年9月にまとめた「Object-based media report」ではオブジェクトをレイヤー、チャンク、トランスメディアに3分類している。

【レイヤー】

レイヤーは他のオブジェクトと一緒に消費されたり、切り替わったりするように設計されたオブジェクトである。例えば字幕、手話映像、解説、グラフィックなど。

【チャンク】

チャンクとは番組の一部を構成するメディアオブジェクトのことで、ストーリーのシーン、シーケンス、セクション、パッケージなどを指し、これらはビデオファイルであることが多いが画像やオーディオであることもある。

【トランスメディア】

トランスメディアは予告編、メイキング映像、NG集、ソーシャルメディアページ、ブログ記事などのような周辺にあるコンテンツである。

OBM化のメリットと課題

OBM化されたコンテンツは、検索エンジンによってインデックス化することも可能である。これによって番組から個々のオブジェクトを自動または手動で抽出して再生することができる。インデックス化によって番組のパーソナライズも可能だ。番組の冒頭部分であらかじめ選択した嗜好や、視聴者のプロファイルに保存されている嗜好、あるいはその時視聴可能な時間尺、たとえば10分で見たいといったような情報に基づいて、自動的に最適な時間にまとめられたバージョンを提供することができる。倍速でコンテンツを視聴している人々の行動からするとこれは理にかなっている。例えばニュースコンテンツでは、個々の記事単位でテキストと写真や動画、音声をそれぞれ独立したオブジェクトとして提供する。これらのオブジェクトにはユニークなフラグが設定されており、例えば自分の住む地域の動画ニュースだけをクリッピングして見ることができるようになる。

また、画面上のレイヤーを活用することもできる。たとえばスポーツコンテンツにおいて、特定の選手に関連したインフォグラフィックスをダイナミックにレンダリングして表示するようなものだ。これは同時に画面解像度に依存しない最適化されたグラフィックスを提供することも可能にする。8K大画面で視聴していてもスマートフォンで視聴していても、前述のような特定の選手に関連したデータグラフィックスを完璧なオーバーレイで実現できるようになる。映像だけではなく、音声領域でも同様にレイヤーを使用することで、さらにアクセシビリティを向上させることができる。

OBMがその可能性を発揮するためには、克服すべき多くの課題がある。従来の制作プロセスにおいては、メタデータの多くは制作過程でレンダリングなどをする際に失われてしまう。制作のためのツール内でワークフローを再構築し、この情報を保持し続けること、そしてそのデータは共通の方法で記述されている必要がある。すなわちオブジェクトと関連するメタデータを業界全体で共有できるようにし、相互運用とコンテンツ管理を可能にする1つのOBM標準を構築する必要がある。DVBはそのための標準化作業も行っていく。

IBC2022で欧州がイメージするメタバースとは

IBC2022では、メタバースは決してバズワード扱いでは無く、技術的な裏付けのある、現実的だが希望に満ちた挑戦として取り扱われている。メタバースは、仮想現実(VR)と拡張現実(AR)を用いて、ユーザーは物理的な存在を体感しながらも、実際には仮想空間や遠隔地などのイベント、パフォーマンスなどを体験できる、没入型の、時にはインタラクティブな環境を作り出すものだ。これは当面はヘッドマウントディスプレイ(HMD)を装着することで実現される。

もちろんメタバースはHMDが絶対に必要であるわけではないが、当面はHMDでリアルな3D映像を長時間、違和感なく楽しめるシステムを実現できるかだ。その近未来が見えたときのために、DVBは常に技術進化を見据えながら標準化作業を継続している。配信フォーマット、プロトコル、ソフトウェア、容量は、時間とリソースがあれば必ず発見、開発することができるからだ。しかし、実際に市場に受け入れられるかどうかは、ユーザーエクスペリエンスの質に強く依存する。これはまさに挑戦なのである。

メタバースは我々の生活の中で重要な位置を占めるようになると予測と期待をされている。ビジネス、ショッピング、医療、イベント、エンターテインメントなど、様々な場面で活用され、インターネットの進化の一端を担うことになる。

メタバースが本当に人々の支持を得て成功するためには、多くの革新的な技術、プロトコル、そしてイノベーションが必要となる。その中でも前述したOBMは特に重要になる。異なるメタバース間の相互運用性も必要だ。普及には時間はかかるだろうし、決して現在のリニア放送やメディアを完全に置き換えるのではなく、強力に補完するものになるのだろう。

VRはメタバースにおける基盤となる技術であり、多くの標準化団体が必要なパラメータの検討を行っている。一例としてITU-Rの分科会SG6では、よりリアルに見えるためにはVR画像の画素密度を目の受容体とほぼ同じ密度にする必要があると結論付けている。目の受容体は均等に配列されているわけではなく、いわゆるVR酔いを回避する必要もあるので話は単純ではなく、これをディスプレイ解像度に換算するといくつになるかはまだはっきりしていないようだ。ひとつ言えることは、メタバースの伝送にはギガビット級の高速広帯域がどうしても必要になり、5Gや6Gといった新世代のワイヤレスネットワーク技術を待つ必要がある。それは決して遠い未来ではなく8年先の2030年頃である。

IEEEでは、XMLベースの高水準言語であるX-VRMLを使用してVRを配信するためのプロトコルに長年取り組んできている。またMPEGグループは、VR映像の構築方法に関する規格であるMPEG-VRを策定している。最近ではMeta、Microsoft、EPIC GAMES、Adobe、NVIDIA、IKEA、Unityといった企業グループによる「Metaverse Standards Forum」が設立され、標準規格に基づいた相互運用性の高いメタバースの実現を目指している。DVBはこうした動きと常に連携しながら、DVB-NIPのような次世代の標準規格を策定し、それを常にアップデートさせている。

放送とメタバースの関連性や親和性はあるのか

放送はもちろん、映像コンテンツはその正確さと高い品質がなければ視聴者の関心を引くことはできない。ここでいう正確さとは、見る人の感覚に忠実であること、そしてコンテンツのコンテキストに即していることを意味する。まず、気が付かないレベルの低遅延でシームレスに表示されなければならない。こうした低遅延を実現するには、テレビ放送がこれまで努力してきた数え切れないノウハウとユースケースと、E2Eでのワークフローが必要不可欠であり、電波は非常に有効な伝送路である。

また主にメタバースを構成するインターネットと同様に、相互接続性は不可欠な要素である。そして、その速度と精度はインターネットプロトコル、つまりIPによって管理される。IPの中核は、異なるホスト間の通信を可能にするトランスポート・プロトコルである。メタバースに必要なレベルのコンピュータパワーと低遅延、あるいは無遅延を考えると、必要なXR技術を駆使してデータコンテンツを移動させる選択肢はNDIしかない。

NDIは、品質を最大限に高めつつ、帯域幅の消費を最小限に抑え、レイテンシーを低減する必要性を維持しながら、IP上でのビデオ移動に関する問題を解決することに重点を置いている。IPビデオの標準プロトコルとして、NDIはメタバースのエコシステムのために必要な相互運用性を促進するのに適した立場にあります。IBC2022でのこのNDIの動向は別記事で紹介する。

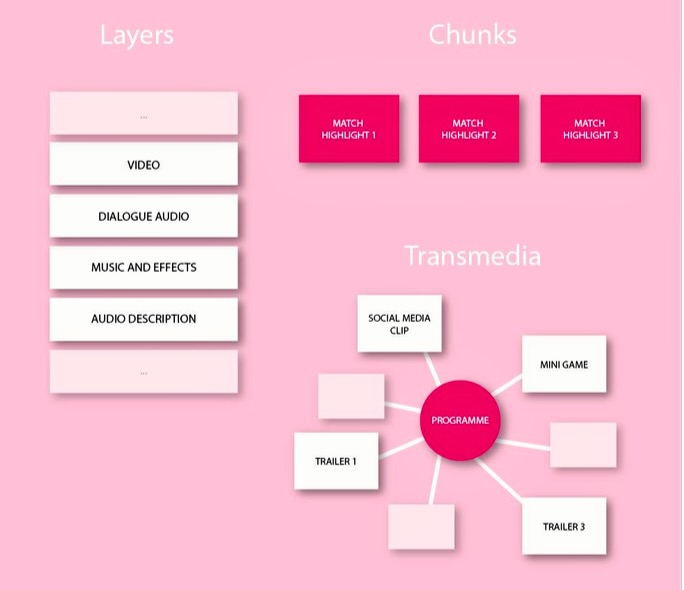

映像関連のさまざまなツールや新技術

こうしたメタバースと放送の関係はどうなっていくのか。これがIBC2022でも大きな議論のひとつであって、答えが見つかっているものではない。ここでいいま抽象的な話だけをしていても実りが得られるわけではないので、筆者が展示やセッション、関連する情報を元にしてまとめてみたい。

まず、コンテンツ制作においてこれまでに提供されている具体的なツールを示していく。これらツールは現時点で完璧なものではもちろん無いが、最新技術に裏付けされたものであり、進化の最中にある。

素材準備領域

・ボリュメトリックな映像素材の新規撮影

・3D、VR、ARパーツ素材をマーケットから購入、シェア(Sketchfabなど)

・2D素材から3D生成(GoogleのLOLNeRFなど)

これらはOBBのために必要となるオブジェクト群の生成に用いられる。

制作(オーサリング)領域

・リアルタイム3D制作プラットフォームでコンテンツ制作(Unreal Engine 5やUnityなど)

・放送用にライブグラフィックスを出力(Viz Engine 5など)

・オブジェクト放送用にオーサリング(StoryFormerやstornaway.ioなど)

ゲームやVFXで利用されているツール群が有効である。たとえばVizrtが先日リリースしたViz Engine5はUnreal Engine 5との極めて高い連携性を持っている。

放送におけるメタバースの扱いに関するいくつかの方向性

(1)放送からメタバースに行く方向性

撮影した素材から人物、モノ、音声を自動で切り出して、メタバース側でも活用する。

(2)メタバースからOBB(放送)に行く方向性

メタバース側のイベントが行われていて、それをメタバース参加者がメタバース内で視聴体験するのに加えて、放送だけで参加する視聴者に向けてゲーム実況的に利用する。

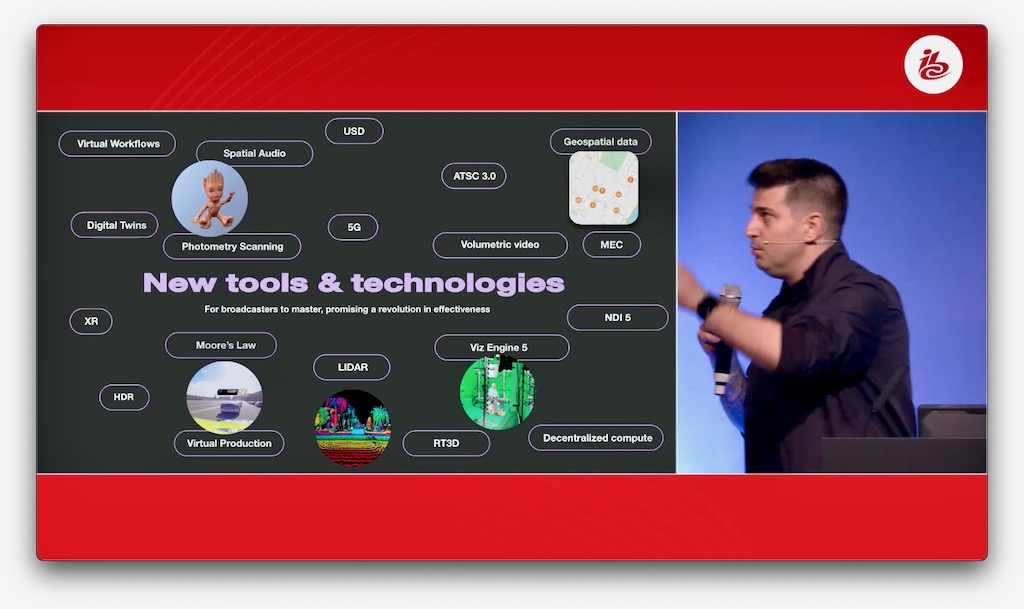

これらを、実際にIBC2022で行われていたデモをベースにして説明してみる。これはBRAINSTORM社のデモの様子であるが、いまから説明するような趣旨でデモが行われていたわけではなく、筆者がこれを元にしてOBMとメタバースと放送の関係性の説明を試みるものである。

まず状況は以下の4シチュエーションあるので、ここではそれぞれを素材1から4と設定し、それぞれの説明を加える。

素材1 ロケーションA(リアルなスタジオ+人物A)

素材2 ロケーションB(別の場所+人物B)

素材3 ロケーションC(LED WALLの中=メタバース)

素材4 ライブプロダクション(ロケーションA+B+C)

素材1はリアルな現場である。ここは観客がいるイベント会場なのかもしれない。素材2は別の場所で、ここではグリーンバックになっている。ボリュメトリックキャプチャーすれば、素材3はLED WALLに表示するための背景映像であるが、この映像自体がメタバースである。その中人物Bで3次元オブジェクトとして存在できるので、ここがゲームのようなメタバース空間であれば人物Bはゲーム空間の中で行動することができる。そしてこれらをカメラで再撮した出力映像(素材4)は従来型の放送で言えば本線映像ということになる。1から4の各素材において、映像はもちろん、音声やセリフ、テロップといったオブジェクトが個別に存在できて、メタバース向け、放送向け(大画面とスマホ用とかも含め)で別々に存在することが可能になる。

このあたりはまだまだ理屈だけの部分が非常に多いと思うが、リアルとバーチャルが映像世界でどう溶け込むことができるのかを理解するためには有効ではないかと思う。こうしたオブジェクトやロケーション、XR、音声やテロップの組み合わせが全て現実的であるわけではなく、今後の様々な試行錯誤やツールの開発を経て、ある程度の絞り込みが行われていくに違いない。

最後に参考として、こうした放送とメタバースの連携という世界観を実現させようとしている、CONDENCE REALITY社のプレゼンテーション映像を紹介しておく。